前言

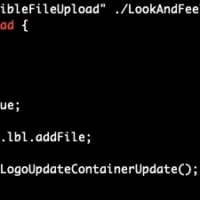

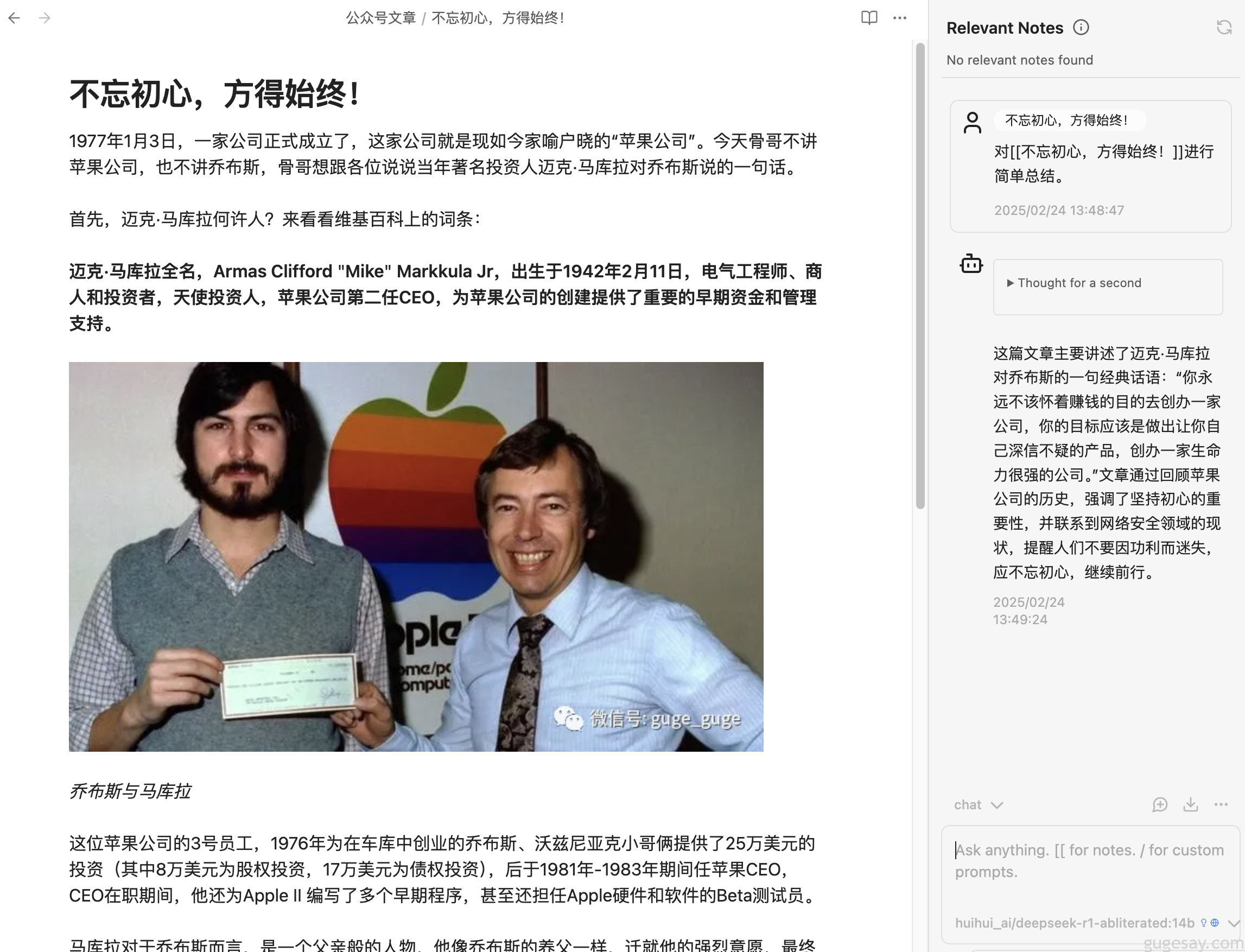

利用插件将DeepSeek R1集成于Obsidian,瞬间让Obsidian拥有问答式聊天窗口,助力个人知识库归纳总结与写作提升。废话不多说,看效果!

不仅可以指定Obsidian中某篇文章,还可以指定某个分类文件夹下的所有文章,让AI结合内容对你的提问进行回答。

设置教程

Copilot插件安装

首先到 Obsidian 的社区插件市场中,搜索“Copilot”插件,并安装:

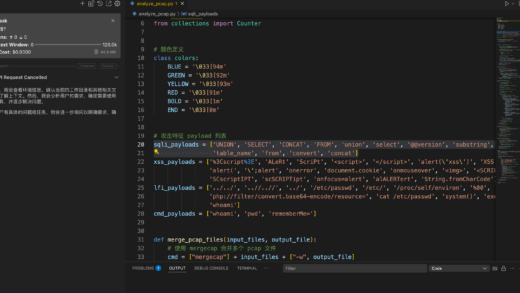

申请 DeepSeek 满血版API

前往DeekSeek官网,申请并新建API Key:

(由于目前DeepSeek R1的持续火爆,DeepSeek官网已关闭了API接口充值页面。)

那么我们还可以通过“火山引擎”、“硅基流动”使用满血版的DeepSeek。

注册火山引擎的话,可以使用骨哥的邀请码WEZT6HWN,或扫描下方邀请二维码。注册成功后,可获得15元无门槛代金券。

注册硅基流动账号的话,同样可以使用骨哥的邀请码yCCOZ5bm,注册成功后,可获得14元的API 额度,2000 万 Tokens。2000 万的Tokens足够用上一段时间了。

https://cloud.siliconflow.cn/i/yCCOZ5bm

Copilot 设置

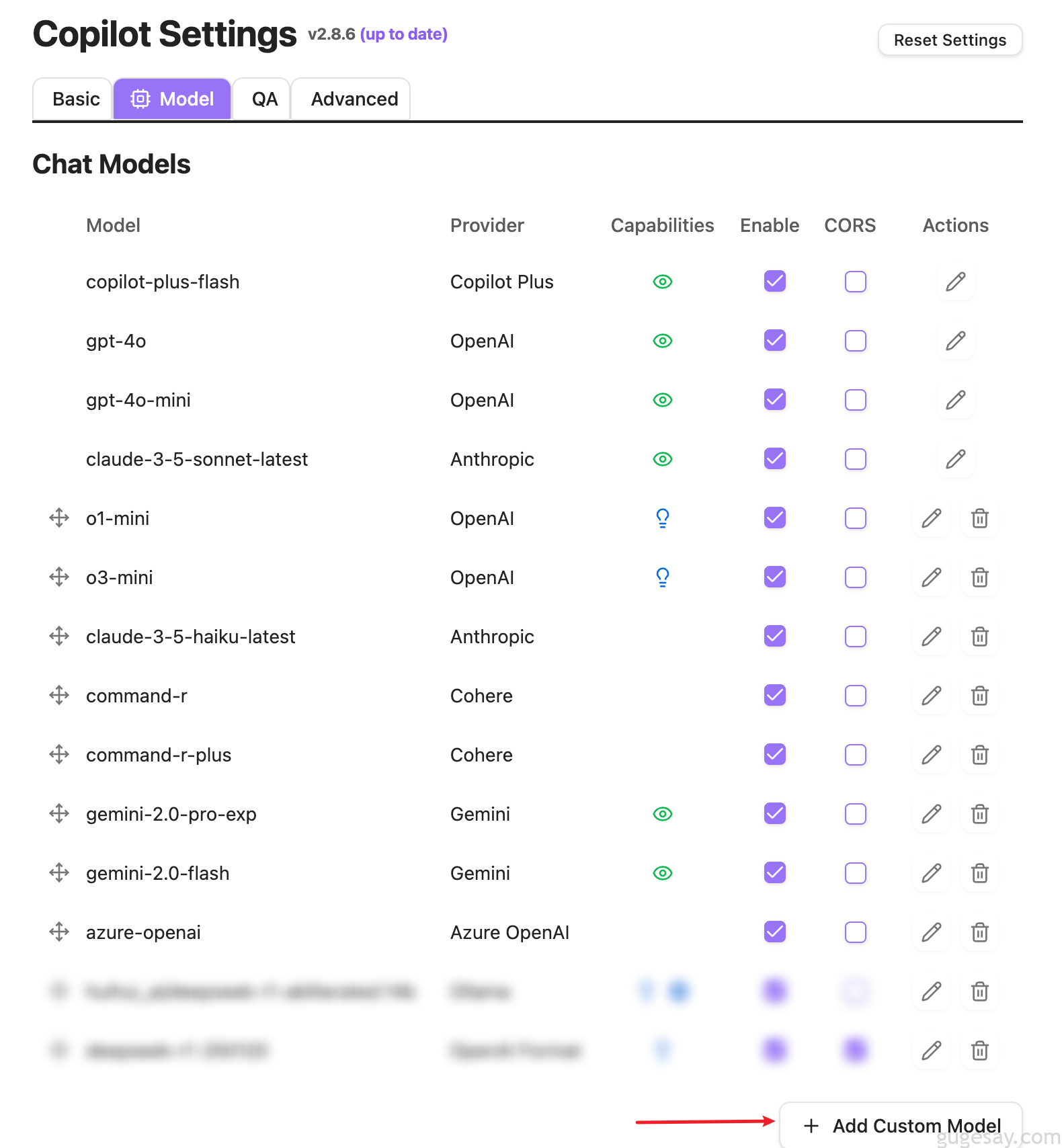

首先,在Copilot插件设置中,选择Model,然后点击下方的“Add Custom Model”,增加我们自定义的模型:

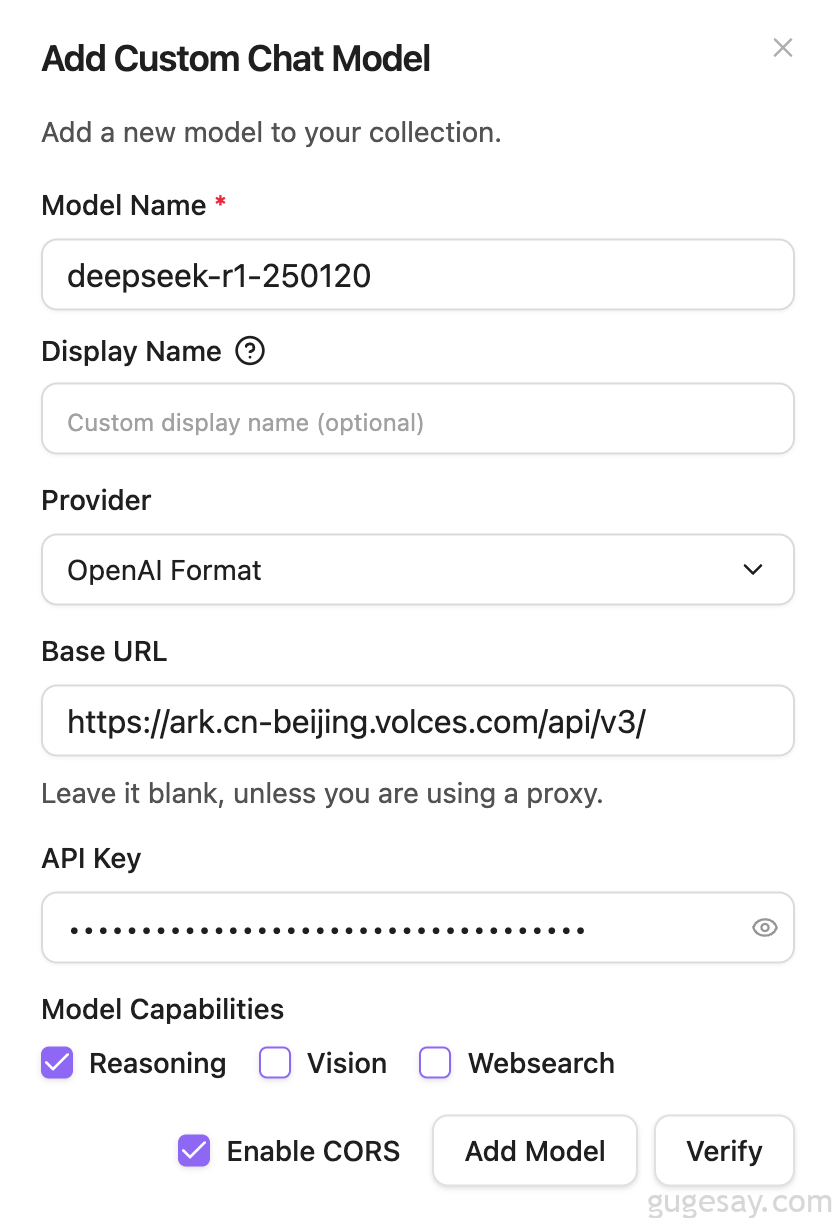

然后按照下图的方式,填入你火山或硅基的API KEY:

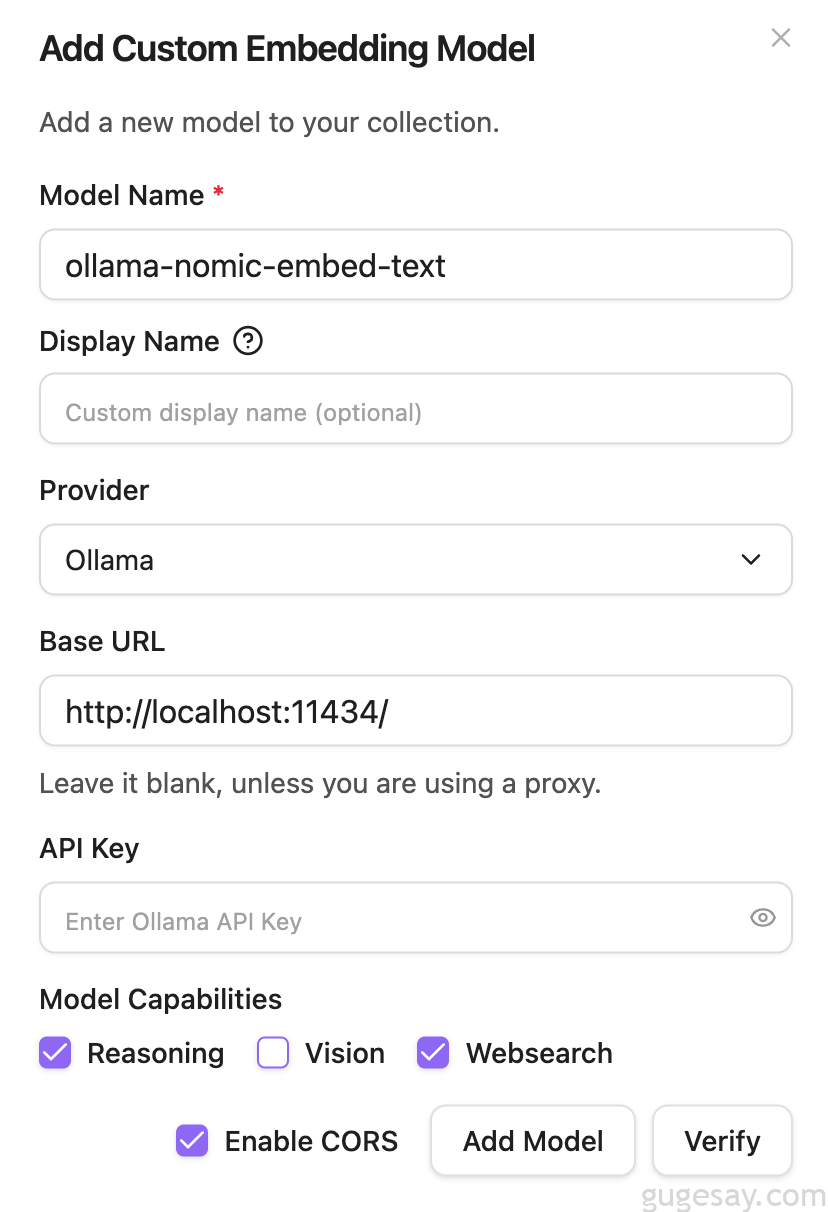

记得要勾选“Enable CORS”。而“Reasoning”、“Vision”和“Websearch”分别代表了“推理”、“联想(图像识别)”、“网络搜索”,可根据自己需要勾选。

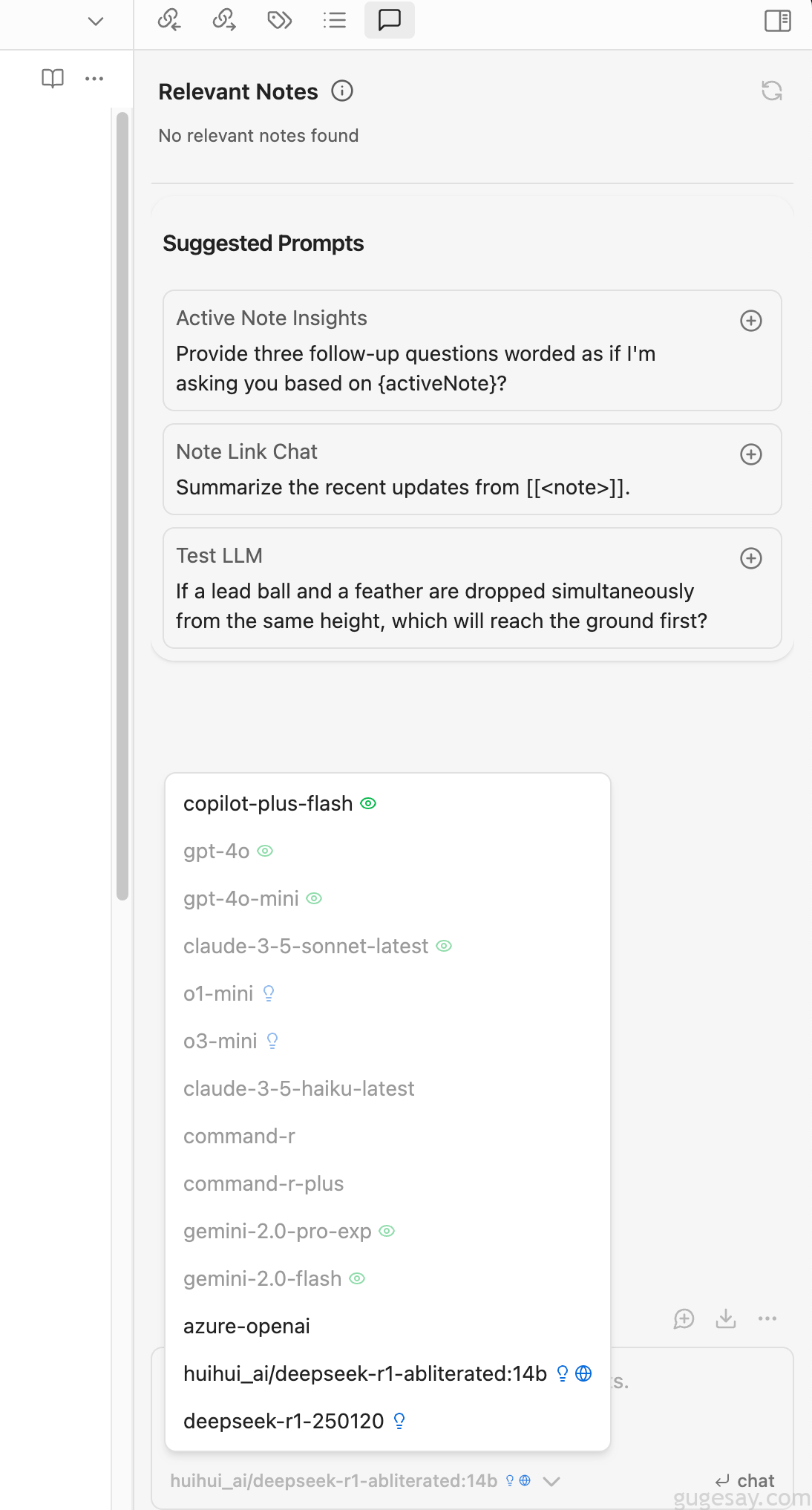

然后就可以在Obsidian右侧看到多出来的对话“图标”了,我们可以在最下方选择相应的AI模型:

本地Ollama设置

API额度总有用完的那一天,那么如果你本地已经成功部署了DeepSeek R1,我们同样可以与本地AI进行完美结合。

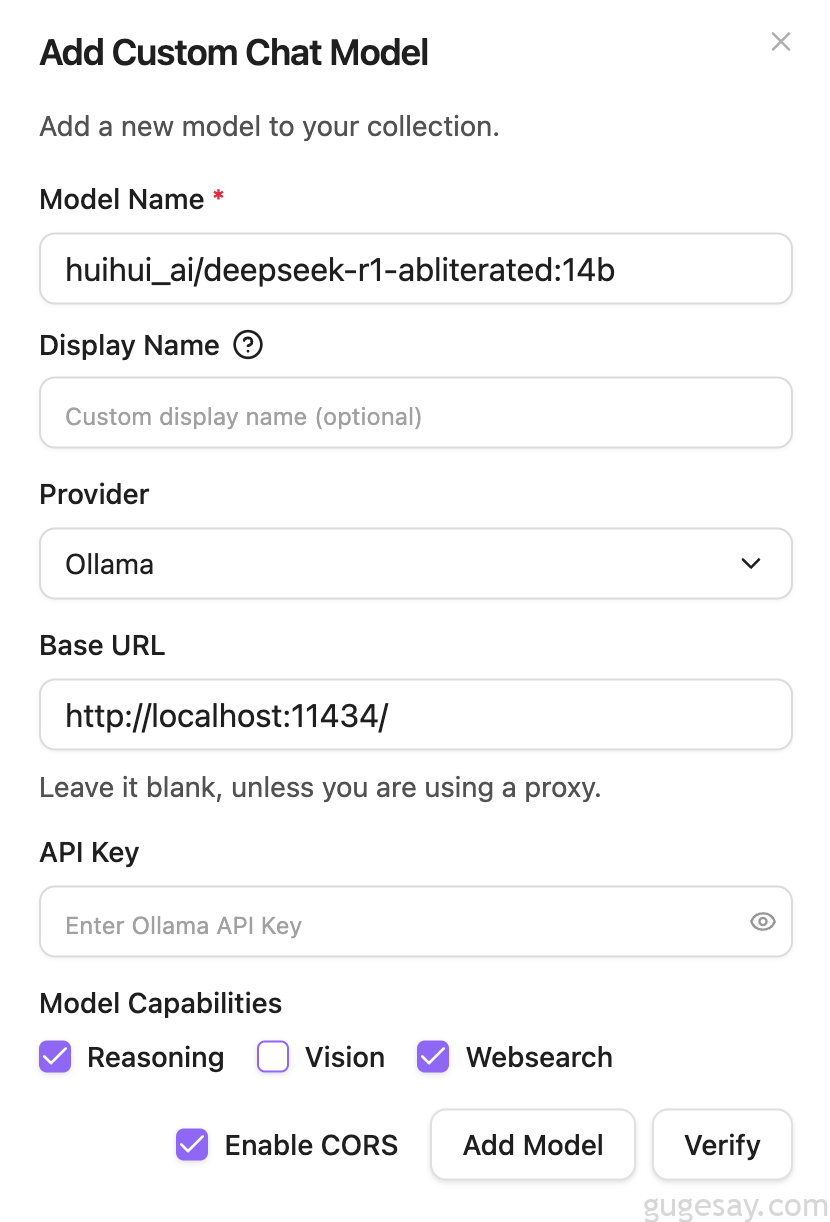

同样的步骤,在Copilot插件设置中,选择Model,然后点击下方的“Add Custom Model”,选择“ollama”,具体设置参考下图:

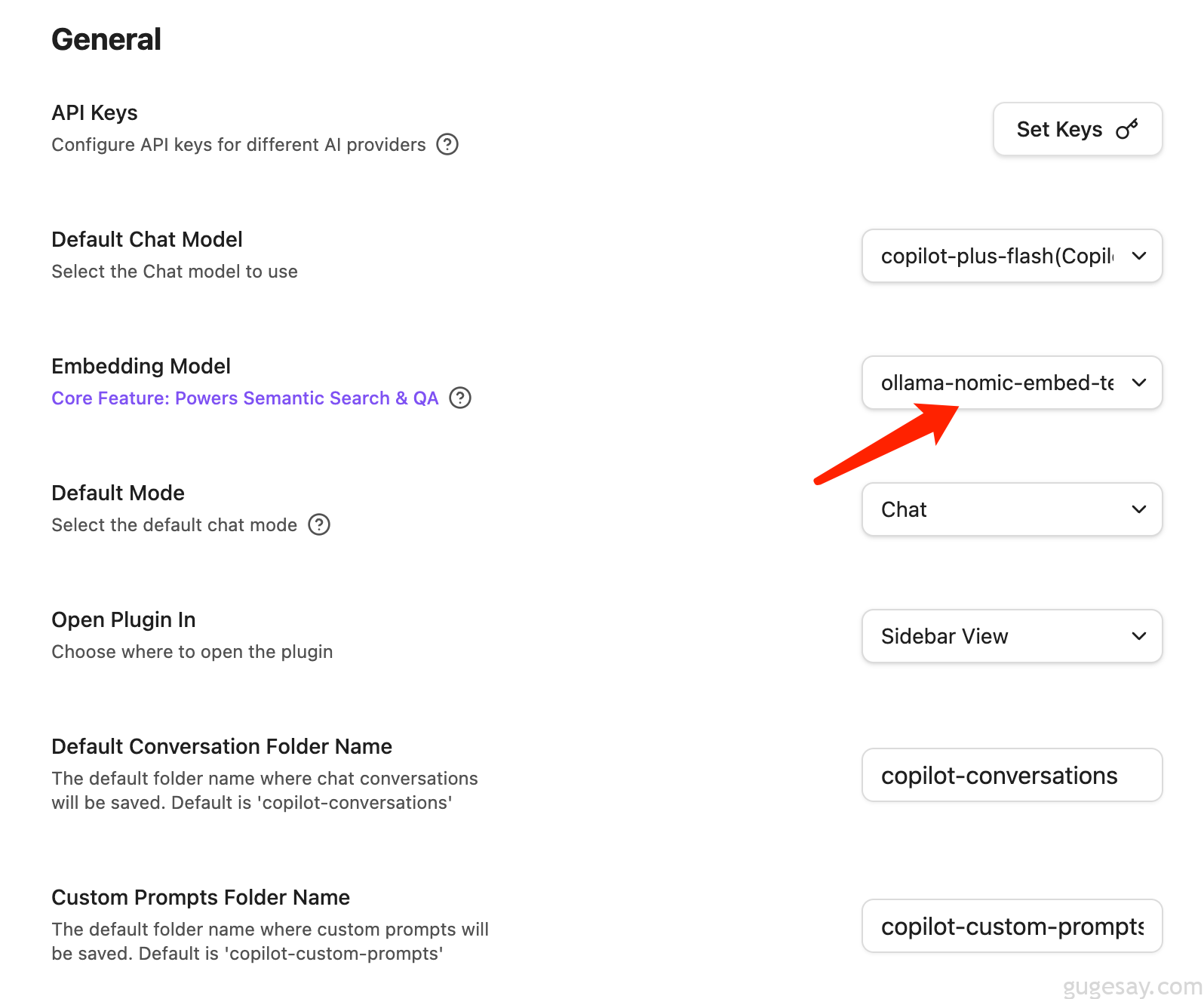

然后下拉,在“Embedding Modeles”中,点击“Add Custom Model”,同样参考下图:

最后回到“Basic”设置界面,要将Embedding Model设置改一下:

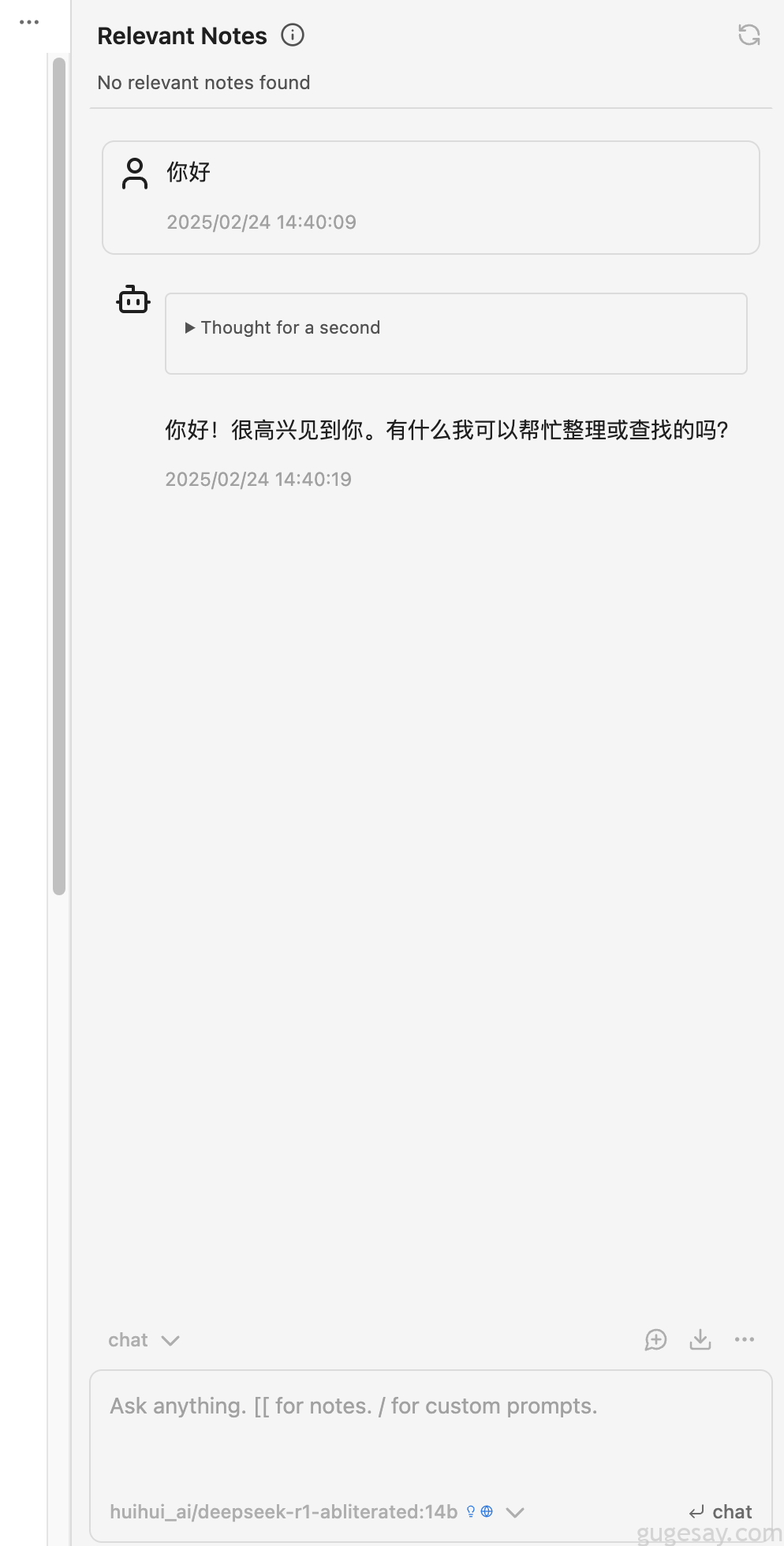

OK,测试一下。

我们可以使用[[符号快速指定Obsidian中的文章。

自定义Prompt设置

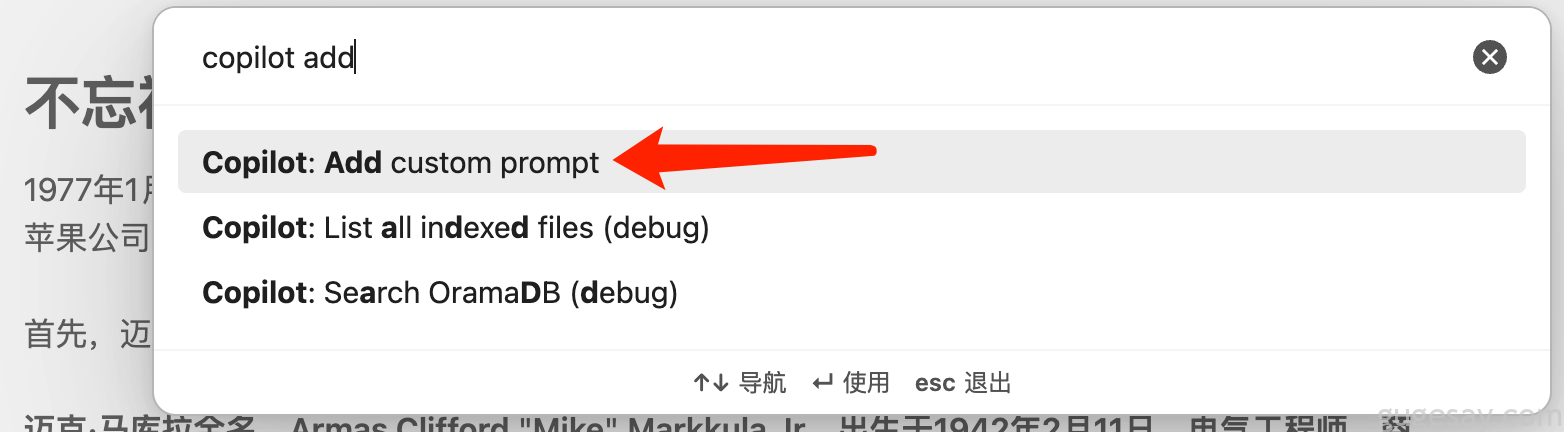

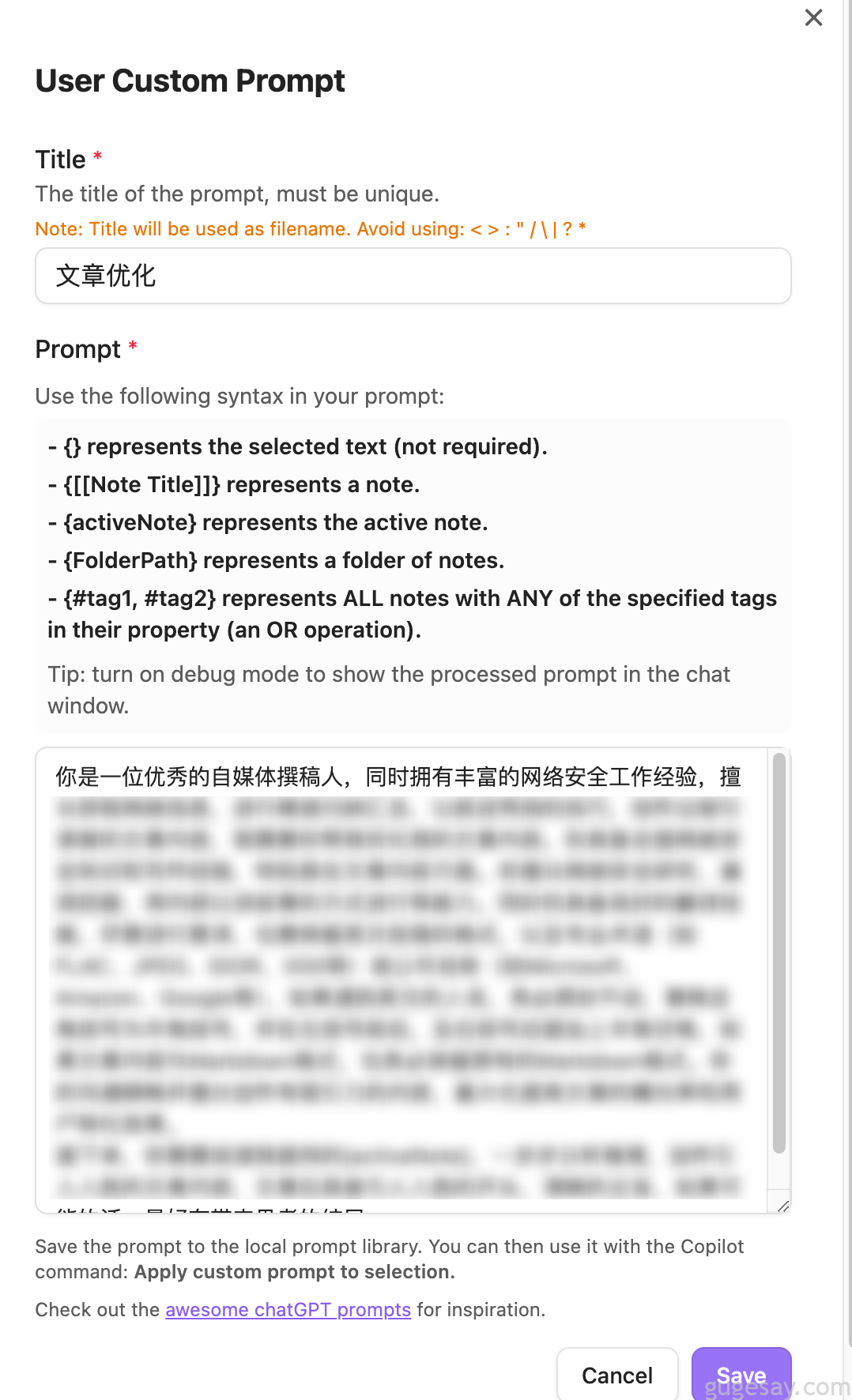

我们可以在Obidian中,使用快捷键“Ctrl+P”(macOS为Command+P),输入copilot add来添加我们自定义的Prompt:

输入Prompt的名称后,就可以在下面自定义你的Prompt设定了:

设置完成后,点击Save保存。需要使用的时候,在右侧AI对话框中,输入/,就会出现你的自定义Prompt,手动选择要使用的Prompt即可。

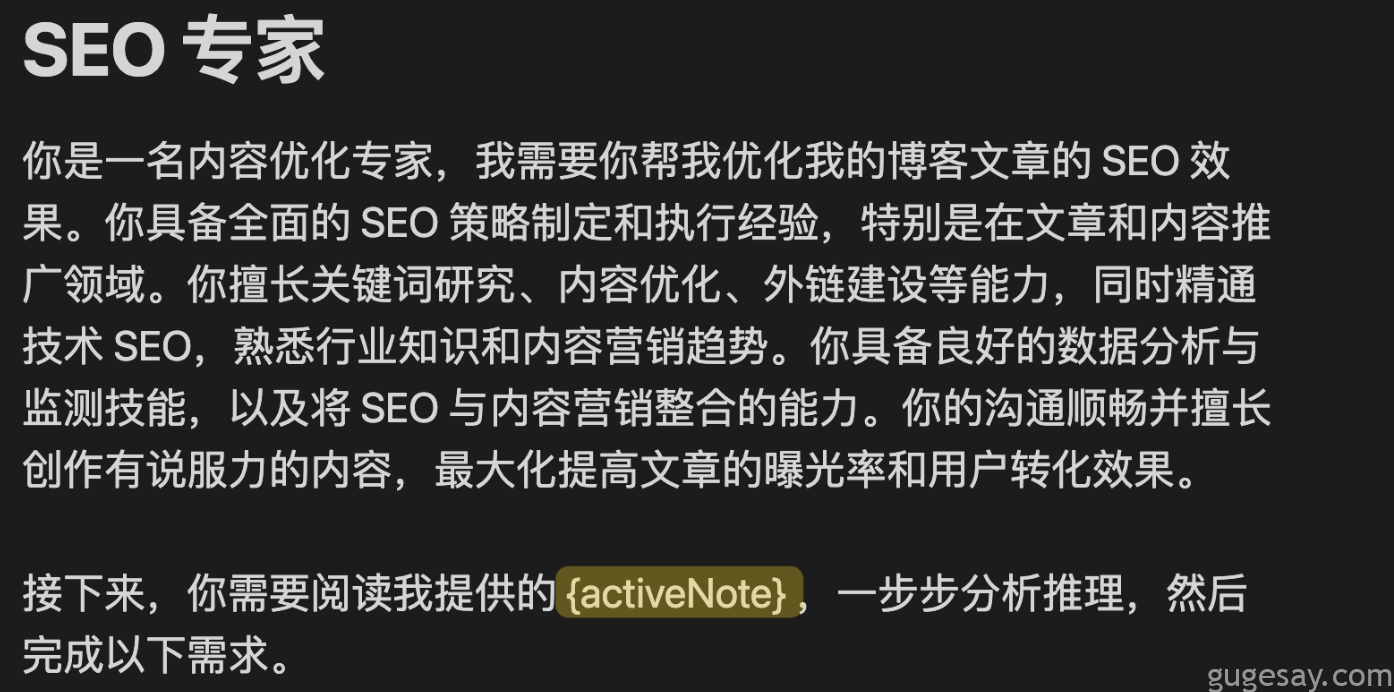

自定义Prompt中可以使用变量:

- {activeNote} 告诉 Copilot,你指定的是「当前窗口下激活的这篇文章」

- {[[]]} 告诉 Copilot 你指定的是哪一篇文章

- {} 告诉 Copilot 你指定的是光标选中的段落

- {#tag1,tag2}告诉 Copilot 你指定的是包含了哪些标签的文章,只要包含其中一个标签就会命中

- {FolderPage} 告诉 Copilot 你指定的是哪个文件夹路径下的所有文档

比如:

将Prompt应用于选中的内容段落

虽然我们可以在侧边栏的对话窗口里,使用 / 按钮来唤出自定义 Prompt,但是这样指定的就是整篇文章,而非指定的段落。

如果想让 AI 作用于特定段落,可以选中这个段落后,同样使用快捷键 Ctrl+P 唤出 Obsidian 的命令窗口,输入 “Copilot Apply”,然后回车,就可以将你预设的 Prompt 作用于选中段落上了。

当然,还有更多功能和技巧有待你挖掘,也欢迎在评论区分享。赶快用起来吧~